咨询服务热线:400-0698-860

邮箱:info@chaoqing-i.com

业务中心 - 上海超擎数智科技有限公司:上海市徐汇区龙启路158号1幢灿星大厦19层1911

业务中心 - 北京超擎数智科技有限公司:北京市海淀区北三环西路99号西海国际中心1号楼907

研发中心 - 武汉超擎数智科技有限公司:武汉东湖高新区金融港二路9号联发科武汉研发中心2楼

当一台 NVIDIA DGX Spark 的性能已经堪称"桌面级AI超级计算机",那么将两台、四台通过200Gb/s RDMA网络直连,又将引爆怎样的性能革命?这不仅是一个技术问题,更是超擎数智在为客户设计AI算力方案时,必须精准回答的实战命题。本期,我们将通过真实的NCCL测试数据,为你精准测绘这个桌面级统一内存集群的能力边界。

1、趋势:单机虽强,但集群才是未来

NVIDIA DGX Spark作为划时代的“桌面级AI超级计算机”,单机即拥有128GB的统一系统内存,足以在本地处理2000亿参数的大模型。

当然,当模型规模持续扩大,或我们追求极致的训练速度时,单机的性能天花板便达到瓶颈。 此时,我们必须引入Scale-out扩展————即通过高速网络将多台机器组成一个统一的计算集群。

这引出了一个核心问题:当我们把多台DGX Spark连接起来,网络是否会成为新的瓶颈? 整个集群的效率,究竟取决于什么?

答案,藏在NCCL(NVIDIA集合通信库)基础库里。它就像是连接多个GPU的“神经系统”,负责所有机器间的数据同步。它的性能,直接决定了多机训练的有效算力。

因此,对NCCL进行基准测试,绝非纸上谈兵,而是为了:

2、实战:构建一个高速无损的测试环境

我们的目标很明确:实测两台及四台DGX Spark通过200Gb/s RoCE网络直连时,NCCL通信性能,量化all_gather/all_reduce等操作的带宽、延迟及扩展效率,验证DGX Spark Scale-out的可行性边界。

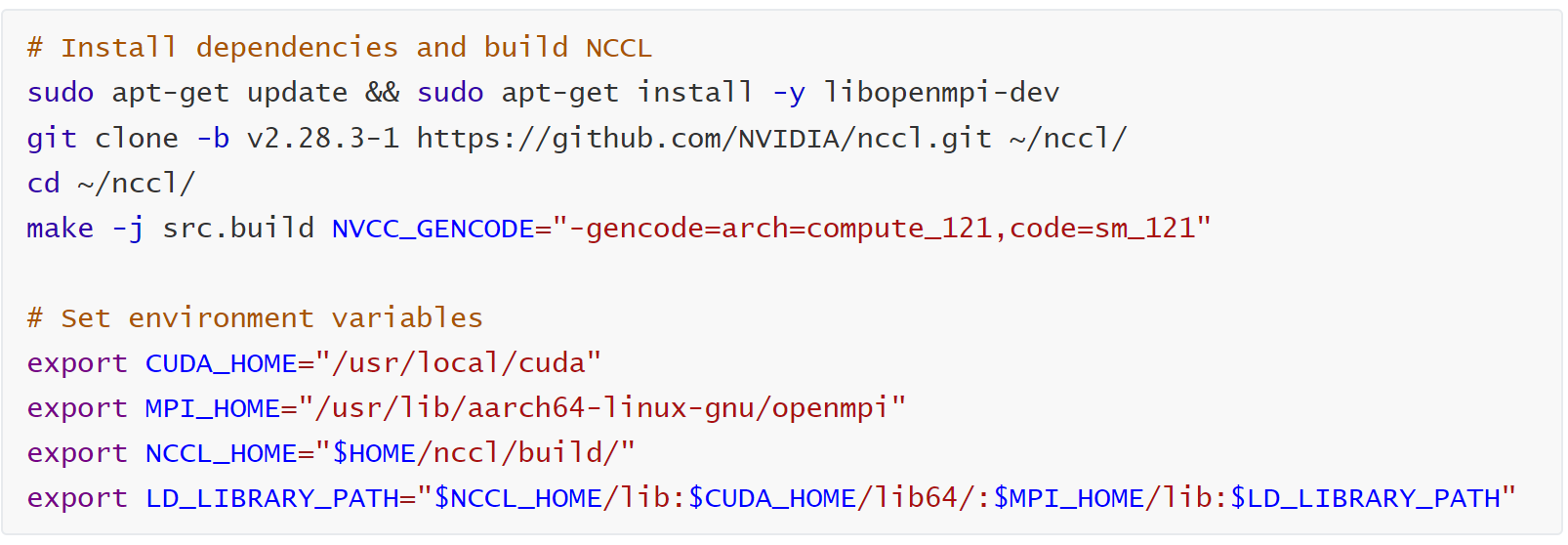

为此,我们搭建了一个精密的测试环境。首先,使用适配Blackwell架构NCCL源码进行编译安装,并配置合适的网络接口。我们特别选择了连接到两个不同CPU的网卡接口(例如enp1s0f0np0和enP2p1s0f1np1),并确保它们位于不同网段,以最大化测试结果的可靠性。

(以下测试过程,技术细节保留,供深度参考)

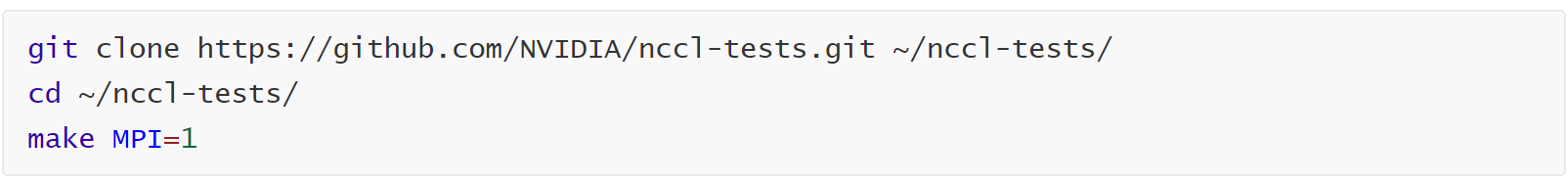

编译NCCL测试套件

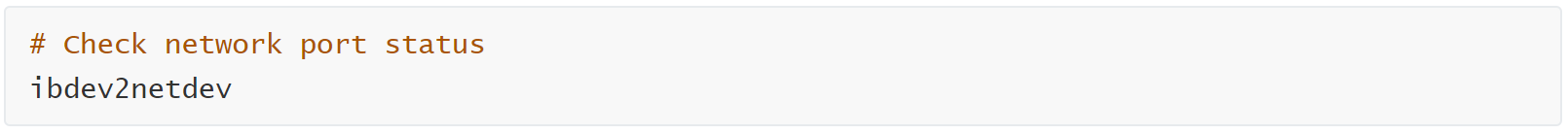

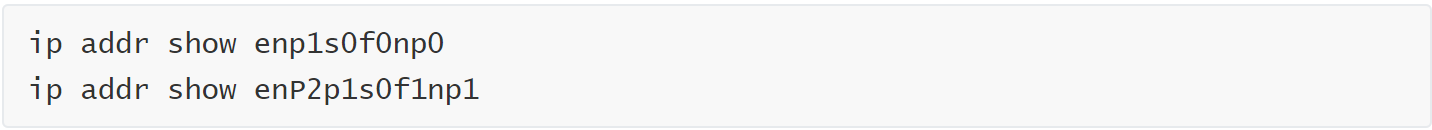

查看网络接口和IP地址

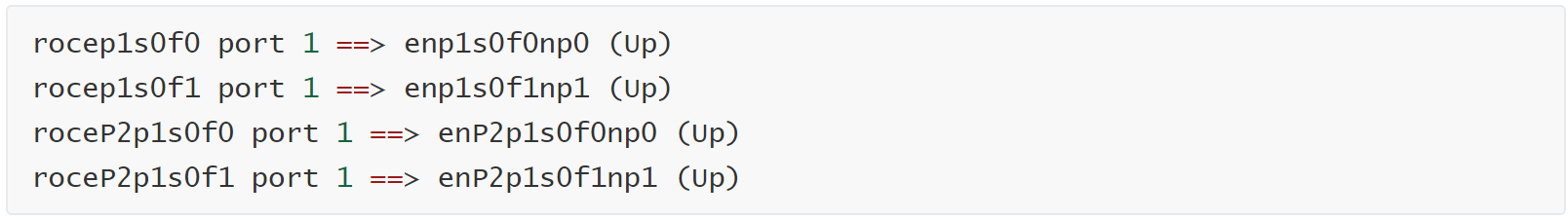

示例输出:

注意:使用连接到两个不同CPU的接口。在这个例子中,我们将使用enp1s0f0np0和enP2p1s0f1np1。

您需要找到两个接口的IP地址。在这两个节点上,运行以下命令以查找IP地址并记下它们以进行下一步。确保两个接口配置在两个不同的网段上。

示例输出:

在节点二重复同样的操作过程。

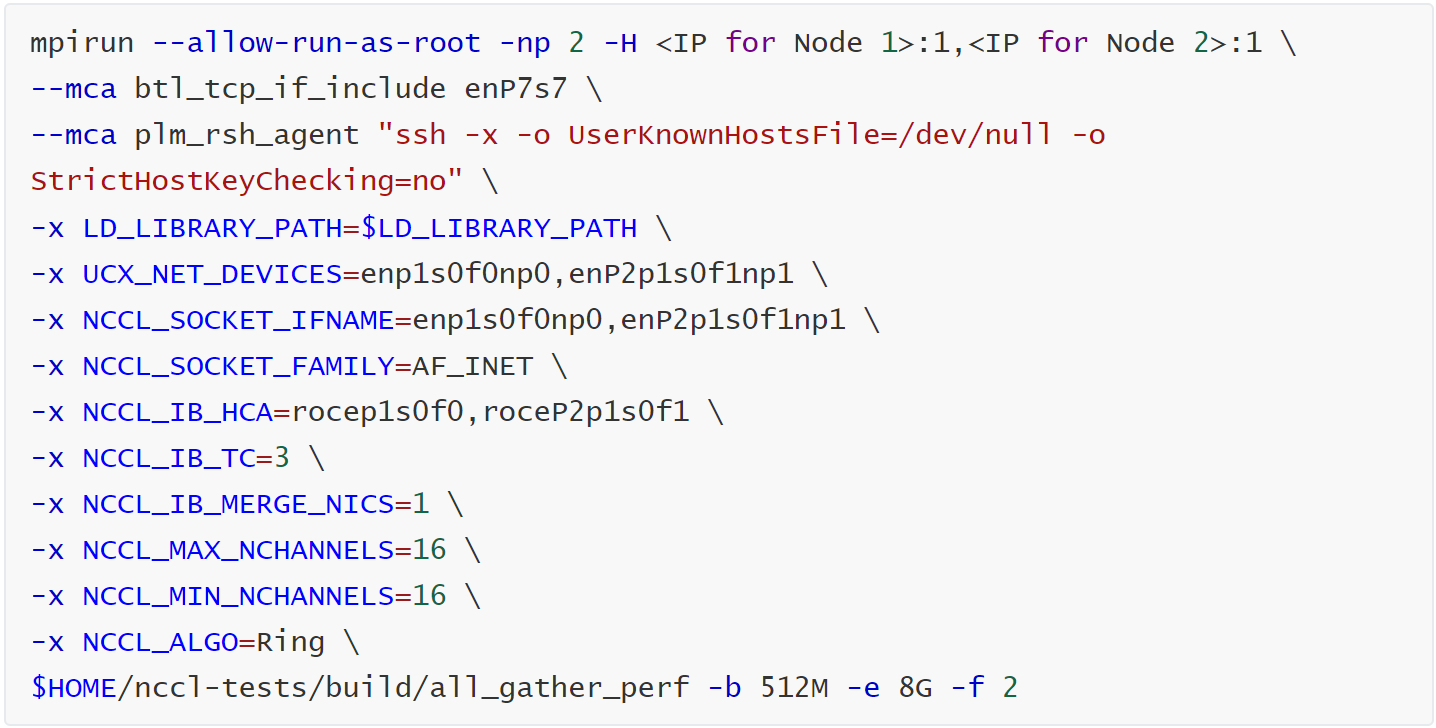

运行NCCL测试

执行以下命令以运行NCCL通信测试。替换上一步中使用的接口名称。

测试结果

3、揭晓:数据背后的性能真相

这些数据意味着什么?

简单来说,它们证明了多台DGX Spark通过高速直连,成功构建了一个高效、低通信开销的微型集群。数据在机器间的“流动”非常顺畅,网络没有成为制约算力释放的短板。

测试数据给予了我们坚实的决策依据。基于此,我们为您提炼出以下部署建议:

“直连”两台DGX Spark,是小规模模型训练和验证的首选。但当同时需要高速互联和外部网络连接时,“直连+交换机”架构提供了更佳的平衡性,能带来更灵活的扩展性和集中管理能力,便于构建桌面级AI集群。选择正确的互连方法可以最大限度地发挥DGX Spark的计算潜力,为AI训练和推理提供高效且可扩展的基础设施。

技术测评的终点,是超擎服务的起点。 超擎数智交付的从来不仅是硬件设备,更是经过实测验证的AI应用全栈支撑能力。 我们相信,精准的测试与前瞻的规划,是构建高效AI基础设施的前提。在通往数智化的道路上,超擎数智愿以自身在算力与网络领域的深度实践,与每一位创新者同行。

公众号

电话

需求反馈